Intelligence artificielle, une technologie en demande d’éthique

Sans être devin, on peut dire sans grand risque de se tromper que l’intelligence artificielle sera la révolution de notre siècle. Celle-ci vient à la rencontre de la technologie, de l’humain, de l’éthique et de la morale. Et c’est ce qui la rend si passionnante. Plusieurs acteurs de l’IA comme DeepMind ont déjà incorporé les notions d’éthique au cœur de leur culture d’entreprise, car faire la science avec conscience est ici la seule voie possible.

Dans un précédent article sur les étonnantes applications de l’apprentissage profond, j’avais abordé les premiers succès de la société DeepMind qui étaient d’avoir développé, au début des années 2010, un agent intelligent capable de devenir par lui-même un champion de différents jeux vidéo. Grâce à la technique de l’apprentissage profond par renforcement (« Deep reinforcement learning »), le programme essaye d’abord de découvrir le fonctionnement du jeu par la méthode essais-erreurs puis affine progressivement sa technique avec un seul but, obtenir le meilleur score. Et la stratégie s’est révélée redoutablement efficace sur des jeux classiques comme Breakout, Pong et Space Invaders.

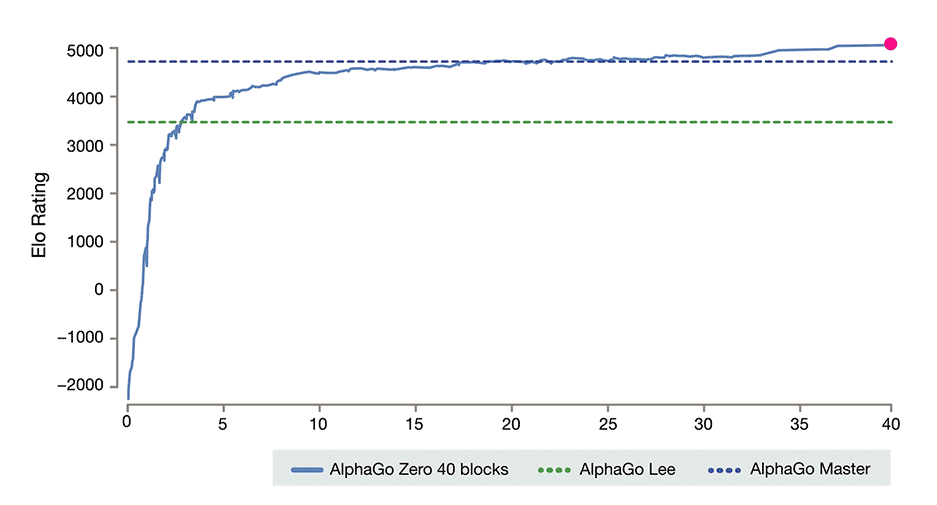

Depuis, la startup anglaise est devenue une grande entreprise et un important acteur de l’intelligence artificielle à l’échelle mondiale. Rachetée par Google/Alphabet en 2014 pour plus de 500 millions de dollars, elle est aujourd’hui présente non seulement à Londres, mais aussi à Mountain View en Californie et à Edmonton et Montréal au Canada. Et le logiciel champion de Breakout est devenu AlphaGo Zero, qui peut apprendre et maîtriser en quelques heures les jeux plus complexes, comme le go, les échecs et le shogi, simplement en jouant contre lui-même et sans recours à une bibliothèque de parties jouées par des humains. Au jeu de go, il surpasse ses itérations précédentes comme AlphaGo Lee, le logiciel qui avait battu les champions du monde Lee Sedol et Ke Jie, devenant sans doute le joueur de go le plus fort de tous les temps.

Progression du classement Elo d’AlphaGo Zero en 40 jours, comparée aux meilleurs classements des versions précédentes, Lee et Master. © DeepMind.

Un détail intéressant sur la transaction de 2014 est que DeepMind avait posé une condition pour accepter l’offre de Google : qu’il soit institué un comité d’éthique et de sécurité ayant, entre autres, le pouvoir de contrôler les transferts de technologie entre DeepMind et Google. Les questions morales et éthiques sont en effet au cœur de la culture de l’entreprise et une appréciable partie de ses chercheurs travaillent dans ce domaine. Ces questions ne sont pas à prendre à la légère : Nick Bostrom, le philosophe suédois qui enseigne à l’université d’Oxford, avance dans son livre Superintelligence paru en 2014 que des super-intelligences artificielles pourraient finir par détruire l’humanité en donnant la priorité à ses objectifs simples, à l’exclusion de tout le reste.

Nick Bostrom. Université d’Oxford, CC Attribution 4.0.

« À mon avis, il est tout à fait approprié qu’une organisation qui a pour ambition de ‘solutionner l’intelligence’ dispose d’un processus de réflexion sur ce que voudrait dire la réussite, même s’il s’agit d’un objectif à long terme », a déclaré M. Bostrom l’année dernière au quotidien britannique The Guardian qui l’interrogeait au sujet du comité d’éthique de DeepMind. « La création d’une IA ayant les mêmes puissantes capacités d’apprentissage et de planification que celles qui rendent les humains intelligents sera un tournant décisif. Lorsque nous y parviendrons, cela soulèvera une foule de questions d’éthique et de sécurité qu’il faudra examiner attentivement. Il est bon de commencer à les étudier à l’avance plutôt que d’attendre la veille de l’examen pour se préparer. »

Parmi les lanceurs d’alerte, on compte aussi Stephen Hawking qui avait déclaré en 2014 à la BBC : « Le développement de l’intelligence artificielle complète pourrait signifier la fin de la race humaine. » L’année suivante, Bill Gates exprimait lui aussi ses inquiétudes sur le futur de l’IA. Le fondateur de Microsoft avait dit qu’il ne comprenait pas les gens qui n’étaient pas troublés par la possibilité que l’IA puisse devenir trop forte pour que les gens puissent la contrôler, contredisant ainsi l’un des chefs de Microsoft Research, Eric Horvitz, qui avait déclaré qu’il ne considérait pas « fondamentalement » l’IA comme une menace. La déclaration de Bill Gates suivait celle faite par Elon Musk devant un parterre d’étudiants de l’Institut de technologie du Massachusetts (MIT) : « Je pense que nous devrions faire très attention à l’intelligence artificielle. Si je devais deviner quelle est notre plus grande menace existentielle, c’est probablement celle-là. Nous devons donc être très prudents. » Et l’entrepreneur d’ajouter : « Avec l’intelligence artificielle, nous invoquons le démon. »

Sans vouloir diaboliser à tout prix l’intelligence artificielle, il paraît raisonnable de poser des garde-fous à la recherche et à l’utilisation de la technologie. Aussi, il est tout à fait estimable que DeepMind se dote d’outils comme un comité d’éthique et contribue à la recherche sur la sécurité de l’intelligence artificielle (« AI Safety ») pour faire en sorte que les futures superintelligences soient amicales plutôt qu’hostiles. Vous n’avez sûrement pas envie d’être à l’avenir à la place d’un David Bowman à argumenter avec un HAL 9000 dysfonctionnel sur un sujet d’importance tout humaine : votre propre survie.

Comme pour d’autres technologies qui ont fait naître des désastres dans le passé, ce n’est pas tant intrinsèquement que la technologie est porteuse de danger, c’est plutôt ce qu’en font les humains. Deux écueils peuvent mener à la catastrophe : de mauvaises intentions (par exemple créer une bombe nucléaire pour tuer un maximum de civils) et une mauvaise maîtrise technologique (par exemple la fusion du cœur de la centrale Tchernobyl).

DeepMind s’est déjà penchée sur le problème de la mauvaise maîtrise, car les incidents avec les systèmes d’apprentissage machine, certes bénins, se produisent déjà. Ils prennent la forme de comportements non intentionnels et nuisibles qui sont dus à une faille dans la conception. On a déjà eu des exemples frappants de dérapages inintentionnels d’intelligences artificielles. On se souviendra par exemple du « chatbot » de Microsoft qui était devenu en quelques heures un épouvantable raciste sur Twitter, à tel point qu’il avait dû être débranché et avait suscité nombre de moqueries sur les réseaux et dans les médias.

Victoria Krakovna est une scientifique qui travaille chez DeepMind sur les questions de la sécurité de l’IA. Sur son blogue personnel, elle a rendu public un document où elle recense avec l’aide de collègues des exemples d’agents intelligents qui ont eu des comportements aussi inattendus que non souhaités par leurs créateurs. Beaucoup de ces incidents sont hilarants, mais ils font réfléchir. La plupart mettent en jeu des agents intelligents comme ceux qui ont fait les débuts de DeepMind, aux prises avec des jeux vidéo. Les conséquences des dérapages sont tout à fait bénignes, voire positives tant elles suscitent le rire. Mais, des accidents similaires sur des systèmes mettant en jeu la santé et la sécurité humaine pourraient avoir un tout autre niveau de conséquences et soulèvent des questions de morale et d’éthique. Ce ne sont pas des questions du futur, mais bel et bien du présent, avec des technologies comme la conduite autonome.

Un type intéressant de comportement inattendu est lorsque l’agent trouve un moyen de tricher avec l’objectif qui lui est donné, c’est-à-dire qu’il génère une solution qui satisfait littéralement l’objectif fixé, mais ne parvient pas à résoudre le problème selon les intentions du concepteur humain. Cela se produit lorsque l’objectif est mal spécifié. Dans le tableau de Victoria Krakovna, on trouve l’exemple de l’agent intelligent qui met indéfiniment en pause le jeu Tetris juste au moment de la chute de la brique qui va le faire perdre. L’agent ne perd effectivement pas, mais on ne peut pas dire qu’il gagne. Un autre agent découvre qu’une solution créative pour ne pas être tué dans un jeu est de faire intentionnellement planter le logiciel. Les agents sont très efficaces pour détecter et exploiter les bogues logiciels. Ils réalisent souvent des actions qu’aucun humain n’aurait l’idée de faire, révélant ainsi des failles ignorées. Il y a aussi l’agent kamikaze qui se suicide à la fin du niveau 1 d’un jeu pour éviter de perdre au niveau 2.

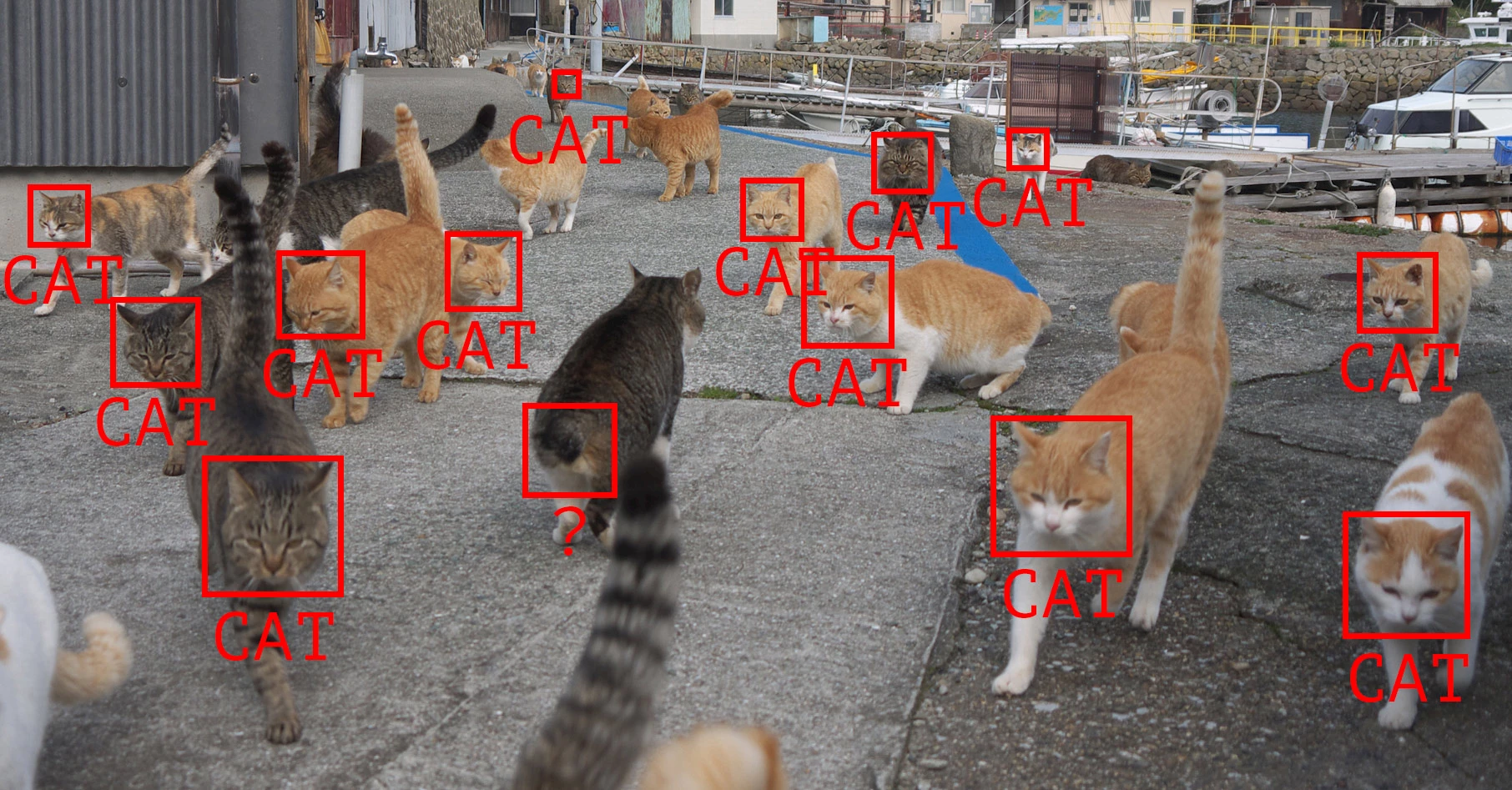

Reconnaissance de chats. © iStock.

Dans d’autres exemples, les systèmes d’apprentissage machine exploitent des failles dans le corpus de données qui leur est soumis. Ainsi, une IA formée à détecter les lésions cutanées potentiellement cancéreuses apprend que les lésions photographiées à côté d’une règle sont plus susceptibles d’être malignes. Un autre réseau neuronal destiné à différencier les champignons comestibles des vénéneux, a tiré parti des données qui étaient présentées dans un ordre alterné pour faire son classement, sans rien apprendre des caractéristiques des champignons. Ces systèmes sont naturellement enclins à tricher, car leur fonctionnement induit souvent de gagner une récompense en délivrant le moindre effort. De nombreux élèves humains ont eux aussi découvert que le meilleur moyen d’avoir une bonne note sans trop travailler était la triche. La différence est que les systèmes d’apprentissage machine ne sont que des outils évolués de tri statistique qui n’ont aucune notion du bien et du mal, aucune notion morale. Dans un tweet humoristique, Joscha Bach, chercheur au Programme de dynamique évolutive de l’université Harvard, a défini le théorème de Lebowski, en référence au héros fainéant du film des frères Coen : « Aucune IA superintelligente ne va s’ennuyer avec une tâche plus difficile que le piratage de sa fonction de récompense. » (“No superintelligent AI is going to bother with a task that is harder than hacking its reward function.”)

Jeffrey “The Dude” Lebowski. © Working Title Films, Universal Pictures.

Plus l’humain va déléguer des responsabilités importantes aux formes d’intelligence artificielle, autres que celles ayant pour objectif de devenir le champion d’un jeu, plus les risques réels vont devenir un enjeu majeur. Des lanceurs d’alertes prestigieux ne sont pas à prendre dédaigner, les dangers sont déjà là et identifiés. Et la complexité des problématiques vient du fait que les applications de l’intelligence artificielle sont au carrefour de la science, de l’éthique et de la morale. Science sans conscience n’est que ruine de l’âme, et excessive confiance dans la technologie n’est qu’aveuglement de l’intelligence. Des entreprises spécialisées comme DeepMind ont à cœur de maîtriser les conséquences de leurs recherches, mais rien n’exclut que d’autres agissent sans cadre, possiblement avec de mauvaises intentions ou pour le moins avec légèreté et insouciance. L’IA peut aussi être détournée par des États, des gouvernements et des groupuscules à des fins néfastes. Les agents « hackers » nous amusent, mais ils soulèvent la question de la sécurité qui va devenir fondamentale aux développements de la technologie et, tôt ou tard, les autorités publiques et les législateurs vont braquer leurs projecteurs sur le sujet. C’est pour cela que les entreprises du domaine, comme DeepMind, font bien d’anticiper et d’incorporer l’éthique au centre de leur pratique.